- Titre :

- L’humanité au risque de la technologie

- Intervenant·e·s :

- Yann Le Cun - Natacha Polony - Gilles Finchelstein - Ali Baddou

- Lieu :

- Émission Le Grand Face-à-face - France Inter - Débat avec notre invité

- Date :

- novembre 2019

- Durée :

- 38 min 30 (à partir de la dix-huitième minute du podcast)

- Écouter ou télécharger le podcast

- Licence de la transcription :

- Verbatim

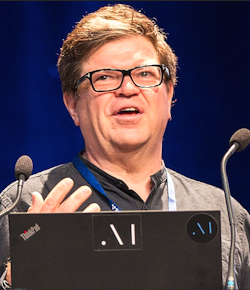

- Illustration :

- Yann Le Cun, lors d’une conférence à l’École polytechnique en 2018, Jérémy Barande - Licence Creative Commons CC BY-SA 2.0

Les positions exprimées sont celles des personnes qui interviennent et ne rejoignent pas nécessairement celles de l’April, qui ne sera en aucun cas tenue responsable de leurs propos.

Transcription

Voix off : France Inter – Le Grand Face-à-face – Le débat

Ali Baddou : L’humanité au risque de la technologie. A-t-on raison d’avoir peur de la révolution de l’intelligence artificielle ou faut-il, au contraire, y trouver des raisons d’espérer ? La question est aussi vieille que la science-fiction. Elle est au cœur d’un nombre incalculable de films, de BD, de romans et c’est maintenant une question d’actualité et un enjeu qui fait débat bien au-delà de la Silicon Valley. D’un côté les catastrophistes, ceux qui craignent de voir les hommes un jour dominés par les machines. Ils nous alertent sur les dangers déjà très réels posés par le développement des technologies – dangers sociaux, éthiques, politiques – et, de l’autre, il y a ceux pour qui les progrès à venir sont immenses, ils concerneraient tous les domaines de nos vies, ils sont vertigineux. Notre invité est de ceux-là. C’est un Français qui est devenu en quelques années l’un des inventeurs qui révolutionnent le domaine de l’intelligence artificielle. Il dirige la recherche fondamentale chez Facebook. Il enseigne à l’université de New-York. Il est lauréat 2019 du prix Turing, le Nobel de l’informatique, et il publie chez Odile Jacob Quand la machine apprend. Bonjour Yann Le Cun.

Yann Le Cun : Bonjour.

Ali Baddou : Et bienvenue. Merci d’avoir accepté le jeu du débat, le jeu aussi de la pédagogie. Quand la machine apprend est un livre passionnant ; son sous-titre La révolution des neurones artificiels et de l’apprentissage profond. Il y a des passages techniques. Il y a aussi des questions extrêmement contemporaines et qui sont dans l’actualité, qui sont justement des défis posés notamment à Facebook. On va en parler dans un instant.

D’un mot, puisque vous êtes l’un de ceux qui inventent notre avenir, expliquez-nous ou rappelez-nous très simplement ce qu’est l’intelligence artificielle.

Yann Le Cun : L’intelligence artificielle c’est donner aux machines la capacité de percevoir, de raisonner et d’agir et, en somme, leur permettre d’accomplir des tâches que d’habitude on réserve aux animaux et aux humains.

Ali Baddou : Natacha Polony.

Natacha Polony : Justement, là on entre immédiatement dans le vif du sujet. Vous dites « de percevoir » et il me semble que ce qui caractérise un être humain c’est qu’il apprend par les cinq sens. Dès qu’il est dans le ventre de sa mère et ensuite dès qu’il est un bébé, ce sont les informations qu’il reçoit par ses sens qui lui permettent de former son cerveau. Quand vous nous dites que le but aujourd’hui c’est de faire en sorte que les machines apprennent de la même façon, il faudrait expliquer de quelle perception on parle puisqu’en fait on travaille sur le visuel. Vous citez souvent la question de la capacité d’une machine à reconnaître un chat par rapport au fait qu’un enfant, lui, a besoin juste de quelques dessins pour immédiatement identifier un chat. Est-ce qu’il ne manque pas aux machines les autres sens, tout simplement ?

Ali Baddou : Yann Le Cun.

Yann Le Cun : Pas forcément. D’abord tout le monde n’a pas les cinq sens.

Natacha Polony : C’est vrai !

Yann Le Cun : Il y a des non-voyants, mal-entendants.

Natacha Polony : Ils compensent par les autres ; il y en a cinq, ça fait beaucoup.

Yann Le Cun : Absolument. Le fait d’avoir plusieurs sens aide certainement à l’apprentissage, ça donne plus d’informations qu’on peut corréler l’une à l’autre. Il y a des recherches sur ce qu’on appelle l’apprentissage multimodal, qui combine le son et la vision par exemple, pas encore trop le toucher parce qu’on ne sait pas encore faire avec les robots, mais ça va venir, on y travaille. Ce qu’on sait faire beaucoup, aujourd’hui, avec les techniques d’intelligence d’artificielle, c’est-à-dire ce qu’on appelle l’apprentissage profond, l’apprentissage automatique.

Ali Baddou : Le deep learning, pour employer le mot qu’on emploie dans la Silicon Valley.

Yann Le Cun : Le deep learning, exactement, on peut relativement facilement permettre aux machines d’apprendre à percevoir, donc reconnaître des images, traduire la parole en texte, ce genre de choses, mais on ne sait pas encore très bien faire la partie raisonnement et la partie action un petit moins. On y travaille aussi beaucoup mais c’est beaucoup moins efficace que les humains. Par contre, ce qu’il est important de savoir, c’est qu’effectivement pour entraîner une machine à pouvoir reconnaître des chiens, des chats, des tables, des chaises, il faut lui montrer des milliers d’exemples d’images en lui disant à chaque fois « c’est un chat, c’est un chien, une table, une chaise » alors qu’effectivement un enfant apprend ce genre de concept avec quelques exemples. Donc on n’arrive pas à l’efficacité d’apprentissage qu’on observe chez les animaux et les humains.

Ali Baddou : D’où le titre de ce livre Quand le machine apprend, parce que lorsque vous parlez d’apprentissage profond, de ce deep learning en bon français, c’est cette révolution qui est en cours : apprendre à la machine à apprendre par elle-même et non plus à exercer des tâches automatiques, même si elles sont extrêmement complexes et pour lesquelles on l’a programmée. Du coup, ce deep learning permettrait aux machines d’être autonomes. Il faut juste nous expliquer à quel point cette révolution est importante. Est-ce qu’il y a des exemples dans le passé, ça peut vous paraître étrange comme question, auxquels on pourrait comparer la révolution que nous sommes en train de vivre avec l’intelligence artificielle ?

Yann Le Cun : Ça dépend un petit peu de l’aspect qu’on considère.

Ali Baddou : Est-ce que c’est la roue ? Est-ce que c’est la découverte du feu ?

Yann Le Cun : Les économistes nous disent que c’est peut-être équivalent à l’invention du moteur à vapeur, de l’électricité, qui ont révolutionné la manière dont on fait un peu tout dans la société, dans l’économie. Ils qualifient ça de « Technologie d’usage général », General Purpose Technology en anglais, GPT par son acronyme, qui va progressivement se disséminer dans toute l’économie et changer un petit peu la manière dont on fait les choses. Un petit peu à la manière dont Internet, il y a une vingtaine d’années, a fait la même chose et la technologie informatique, à peu près au même moment, a aussi transformé la société.

Ali Baddou : Gilles.

Gilles Finchelstein : Je vais vous poser une question sur le monde de l’intelligence artificielle. Vous retracez, dans ce livre, à la fois votre parcours qui est intimement lié au développement de l’intelligence artificielle, donc votre livre permet de bien comprendre les différentes étapes du développement de l’intelligence artificielle.

Ali Baddou : Le parcours c’est un cas d’école ! Je le dis juste d’un mot. Ça part de l’histoire d’un gamin français qui bidouillait, ado, sur son ordinateur dans une banlieue pavillonnaire pas si loin de Paris et pas si loin de là où a grandi Natacha sans trahir de secrets.

Natacha Polony : Je connais bien Soisy-sous-Montmorency.

Ali Baddou : Et qui est aujourd’hui à la tête de la recherche fondamentale et l’un des boss mondiaux de l’intelligence artificielle, notamment chez Facebook. Gilles.

Gilles Finchelstein : On voit les différentes étapes scientifiques, mais on voit aussi les différentes étapes sociétales. En fonction des modes, en fonction des financements, en fonction de la capacité de réception de la société, il y a des étés et des hivers de l’intelligence artificielle. Vous dites que ce qu’a été votre article phare, écrit en 1998 sur les réseaux convolutifs, pendant dix ans il passe à peu près inaperçu et puis il réémerge dix ans, quinze ans et vingt ans après : en 2019 c’est plus de 20 000 citations. On voit bien le jeu entre l’un et l’autre.

Il y a une chose qui m’a surpris sur ce monde de l’intelligence artificielle, c’est que vous le décrivez comme un monde extrêmement coopératif, ouvert. Vous publiez, beaucoup de choses sont en open source. Est-ce que c’est la réalité compte-tenu de ce que sont aussi les enjeux économiques ?

Ali Baddou : Yann Le Cun.

Yann Le Cun : Oui, c’est la réalité effectivement. En fait c’est un petit peu spécial, je dirais spécifique à la recherche en intelligence artificielle. Quelque chose pour lequel j’ai aussi beaucoup milité c’est la pratique de la recherche ouverte et de la communication rapide. Traditionnellement dans la science, le progrès est peut-être relativement lent à cause du fait qu’on met sur pied une expérience, par exemple dans la biologie ça peut prendre deux ans, on fait l’expérience, on écrit un article, on le soumet à un journal, le journal le refuse, on fait une révision, on le soumet à un autre journal, etc. Le délai de publication peut être de un an, un an et demi, deux ans. En fait, le résultat n’est connu que quatre ou cinq ans après que l’idée ait émergé.

Ali Baddou : Et puis si on travaille pour une entreprise privée, en l’occurrence, on ne divulgue pas ses secrets de fabrication !

Yann Le Cun : Au contraire, c’est justement là que les choses ont complètement changé, c’est-à-dire que toute la recherche qu’on pratique à Facebook et aussi, en grande partie, dans d’autres compagnies comme Microsoft et Google, est ouverte, est publiée. En ce qui nous concerne, à Facebook, on publie aussi nos programmes ce qui permet d’essaimer, la communauté de la recherche peut travailler sur des problèmes intéressants, et, en fait, de leur faciliter le travail. La raison pour ça étant que les choses qu’on pourrait construire avec l’intelligence artificielle n’existent pas encore. Le problème de construire des machines intelligentes est un des défis technologiques majeurs ; aucune société, aussi large qu’elle soit, n’a le monopole des bonnes idées, donc il faut aider le reste de la communauté internationale à faire des progrès les plus rapides. Donc ce qu’on fait c’est qu’on a une idée, on fait une expérience très rapide, ce qu’on peut faire avec l’informatique aujourd’hui, on écrit un article qu’on publie immédiatement sur un site qui s’appelle arXiv.org [1] – a, r, x, i, v – j’ai d’ailleurs beaucoup de références à ces articles dans le livre qui sont accessibles à tout un chacun, n’importe qui, c’est gratuit. On peut se connecter et chercher.

Ali Baddou : A condition de pouvoir les comprendre et les lire.

Yann Le Cun : Il faut pouvoir les comprendre, voilà.

Ali Baddou : Aujourd’hui vous parlez à des analphabètes qui n’y ont pas accès.

Yann Le Cun : Ensuite ces articles sont peut-être soumis au processus de pair review comme on dit dans la science, qui demande à d’autres scientifiques de s’assurer de la véracité des résultats ou de la méthodologie. Ça fait que l’échange d’informations est extrêmement rapide donc les progrès sont accélérés. C’est quelque chose pour lequel j’ai beaucoup milité.

Ali Baddou : Natacha.

Natacha Polony : Si j’ai bien compris la notion de circuit convolutif, il me semble que le basculement et ce qui explique que votre article soit resté pendant dix ou quinze ans sans vraiment être compris et sans vraiment avoir de postérité et qu’ensuite, au contraire, il révolutionne tout cela, il me semble que c’est parce que, justement, la question était de savoir dans quel sens on essayait de développer la machine et si on copiait ou si on essayait de comprendre le fonctionnement d’un être humain pour que la machine puisse apprendre de la même manière. En fait, j‘ai envie de vous demander quelle est votre vision d’un être humain ? Dans votre livre vous nous racontez, finalement, votre vision des machines. Quand on travaille comme cela, quand on cherche à faire avancer les machines, il reste quoi de la vision qu’on a d’un être humain et de la spécificité d’un être humain ?

Ali Baddou : Yann Le Cun.

Yann Le Cun : En fait, la quête scientifique derrière tout cela, la motivation, c’est comprendre l’intelligence humaine ; comprendre l’intelligence en général, qu’elle soit animale ou humaine ou artificielle ou l’intelligence des machines. C’est une grande question scientifique, une des trois grandes questions scientifiques du monde aujourd’hui : comment marche l’univers ? Qu’est-ce que la vie ? Comment marche le cerveau ? Ce sont les trois grandes questions, si vous voulez ; vous pouvez raccorder toute la science, la science fondamentale, à l’une de ces trois questions.

Donc en tant que personne ayant la fibre de l’ingénieur, je tiens ça de mon père qui était ingénieur, je pense que pour vraiment comprendre le fonctionnement d’un système il faut pouvoir le construire soi-même, c’est-à-dire ne pas se faire d’illusions sur des idées théoriques qu’on pourrait avoir qui, en fait, ne peuvent pas marcher en pratique. Si on veut vraiment prouver que nos idées fonctionnent il faut les réaliser et montrer qu’elles marchent.

Ali Baddou : Pour répondre à Natacha, si on vous comprend bien, ça veut dire que vous considérez l’homme comme une machine ? Vous êtes très cartésien.

Yann Le Cun : L’homme est une machine, ça ne fait aucun doute.

Ali Baddou : Il y a quelque chose qui relèverait de l’âme, par exemple de l’ordre de l’âme ou de la spiritualité ?

Yann Le Cun : Disons que l’âme c’est comme le logiciel dans un ordinateur, c’est une vue de l’esprit. C’est comme le fonctionnement d’un logiciel, mais ça n’a pas de réalité physique.

Natacha Polony : Sans aller jusqu’à la question du logiciel. Quand on voit, par exemple, ce fantasme qui naît avec le transhumanisme, cette idée qu’on pourrait quasiment télécharger un cerveau sur un disque dur, c’est justement oublier le corps et oublier que l’être humain n’est pas uniquement fait d’influx électriques ; en tout cas c’est tellement complexe que ça en devient une différence de nature et pas une différence de degré. Non ?

Gilles Finchelstein : Si je peux prolonger la question de Natacha. Vous dites, et c’est d’ailleurs assez surprenant, que vous travaillez par intuition ; vous commencez par l’intuition et après viennent les mathématiques. À quel moment y a-t-il de l’interdisciplinarité ? Ce qui permet aussi de répondre d’une autre manière à la question d’Ali Baddou, à quel moment d’autres experts d’autres sciences viennent en interaction avec vous ? Est-ce que ça se fait au niveau de l’entreprise elle-même ou est-ce que ça se fait à l’extérieur ? Vous avez dit que vous avez créé un réseau, vous le développez dans le livre. Est-ce qu’il y a de l’interdisciplinarité, quand et où ?

Ali Baddou : Yann Le Cun.

Yann Le Cun : Il y a beaucoup d’interdisciplinarité. Je vais y revenir dans une seconde. Je vais d’abord répondre à la question du transhumanisme.

Je ne suis pas un adepte du transhumanisme, du tout. La question de savoir si on peut télécharger son esprit dans un ordinateur, si on pourra le faire dans un futur lointain parce qu’il n’y a pas du tout de technologiques qui existent pour ça, si on veut effectivement préserver un peu l’expérience humaine il faudra aussi simuler le corps dans la machine ou peut-être construire des robots qui soient suffisamment fidèles au corps humain et je pense que c’est du domaine de la science-fiction. On n’a aucune idée de comment faire ça, du tout.

Ali Baddou : On est très loin de Blade Runner.

Yann Le Cun : Blade Runner c’est une autre idée, c’est l’idée de construire des robots qui sont, en fait, des humains un peu modifiés, donc c’est une autre histoire.

Pour revenir à la question de la multidisciplinarité, c’est, en fait, à la source de tous mes travaux : je me suis beaucoup inspiré de travaux très classiques en neurosciences, un petit peu en sciences cognitives aussi, pour diriger un peu les recherches. Par exemple, j’ai toujours pensé que l’intelligence était inséparable de l’apprentissage, ce n’est pas le cas de tous les chercheurs en intelligence artificielle, particulièrement les précédentes générations, si vous voulez avant, les hivers qu’on a connus dans le passé où il y a eu un courant de l’intelligence artificielle, dans les années 70-80, un petit peu dans les années 90, qui disait, en fait, le raisonnement humain est un raisonnement logique donc si on peut faire que les machines obéissent à un raisonnement logique avec des règles d’inférence, il suffit d’écrire la liste de tous les faits qui sont vrais et un ensemble de règles de déduction et on pourra faire des machines intelligentes. Ça c’est avéré extrêmement difficile parce qu’on ne peut pas réduire…

Ali Baddou : Ça a été un échec !

Yann Le Cun : Disons que ça a conduit à certains outils qui font maintenant partie de la boîte à outils standard de l’informatique, mais on n’arrive pas à des machines vraiment intelligentes avec ça parce qu’on n’arrive pas, en fait, à réduire la connaissance humaine en une suite de règles et de faits. Par exemple, il est impossible de permettre à une machine de percevoir des images avec ce genre de méthode, pour ça il faut utiliser l’apprentissage. Donc très tôt je me suis dit il faut que l’apprentissage soit à la source de ça. J’ai commencé à m’intéresser à la question quand j’étais étudiant ingénieur, au début des années 80, même fin des années 70, et j’ai essayé de creuser la littérature. Je suis tombé sur des livres qui parlaient un peu d’apprentissage machine, j’ai essayé de creuser la littérature, je me suis aperçu qu’il y a eu des gens qui ont travaillé là-dessus dans les années 50 et 60 et ce domaine a complètement disparu à la fin des années 60 à la suite de la publication d’un livre qui montrait les limitations des approches basées sur l’apprentissage. Donc les gens avaient perdu, à la fin des années 60, l’ambition de faire des machines intelligentes basées sur l’apprentissage. Donc il y a eu une période noire d’une quinzaine d’années et c’est reparti, en fait, au milieu des années 80 et c’est le moment où je commençais ma carrière, donc j’étais juste au bon moment. J’ai inventé quelques techniques qui se sont avérées très utiles, y compris les réseaux convolutifs qui sont inspirés par l’architecture du cortex visuel. Donc il y a beaucoup d’inspiration…

Ali Baddou : Pour le dire rapidement, quand vous travaillez sur l’intelligence vous vous inspirez du fonctionnement du cerveau humain, de la connexion entre neurones.

Yann Le Cun : Pas humain.

Ali Baddou : Pas du cerveau humain ?

Yann Le Cun : Animal.

Ali Baddou : Animal !

Yann Le Cun : En fait, il n’y a pas de différence. On a l’impression que les humains sont très différents des animaux, en fait on n’est pas beaucoup plus intelligents que les orangs-outangs et finalement, ce qu’on recherche ce sont les principes de base de l’intelligence qui sont les mêmes chez tous les mammifères, chez certains oiseaux, etc. Au niveau description, où en sont les réseaux de neurones artificiels aujourd’hui, on n’est pas au niveau humain, on est plutôt au niveau même pas d’un rat, en fait.

Ali Baddou : Même pas d’un rat ! Ce qui est intéressant c’est que lorsqu’on parle d’intelligence artificielle et de cette révolution en cours, on pense voitures autonomes, on pense révolution dans le domaine de la médecine et notamment dans la possibilité de diagnostiquer plus rapidement, plus finement et de manière beaucoup plus accessible des tumeurs, par exemple. Qu’est-ce qu’il y aurait d’autre comme exemples pour que tout le monde comprenne ce dont on parle avant de passer aux questions que ça pose et aux débats que ça suscite ?

Yann Le Cun : Dans ces exemples, ce qui est commun à ces exemples c’est que les machines qui sont entraînées pour faire ces tâches ne sont entraînées que pour faire ces tâches très étroites, donc un type d’intelligence, si vous voulez, dans un domaine très étroit. On les entraîne, par exemple, à reconnaître des espèces d’oiseaux à partir de photos et ils peuvent reconnaître n’importe quel oiseau, probablement avec des performances surhumaines. On les entraîne à conduire des voitures, pour l’instant ce ne sont pas encore des performances surhumaines mais ça va venir ; à détecter des tumeurs dans les IRM ou dans les mammographies, c’est pareil, il y a des performances un petit peu surhumaines de ce côté-là. En fait, les meilleures performances sont obtenues en combinant l’humain et la machine. Donc dans des domaines très étroits, certainement dans les jeux aussi, les machines peuvent être supérieures aux performances humaines.

Par contre, ce que n’ont pas les machines, c’est une espèce de sens commun et d’intelligence un peu plus générale, qu’on retrouve dans l’humanité, dans les primates, etc., et même dans les rats, les rats et les chats ont plus de sens commun que les plus intelligentes de nos machines.

Ali Baddou : Qu’est-ce qui vous permet aujourd’hui de dire que les inquiétudes de ceux qui craignent la catastrophe ou qui disent que la catastrophe a déjà commencé avec l’intelligence artificielle, qu’un jour les machines domineront les humains, que même les développements de l’intelligence artificielle pourraient, à terme, entraîner la fin de l’humanité et ce sont de très grands scientifiques, Stephen Hawking le disait, le grand patron de Tesla, Elon Musk, le répète encore aujourd’hui. Qu’est-ce qui vous permet de balayer ça et dire non, ce n’est pas scénario le plus probable, ni même le plus crédible ?

Yann Le Cun : Il y a beaucoup de questions que les gens se posent effectivement qui sont liées ; on est un peu conditionnés par la science-fiction – les scénarios sont toujours plus intéressants quand il y a des catastrophes – donc on est un petit peu conditionnés par ça. La plupart sont très irréalistes. J’ai tout un chapitre dans le livre qui essaie de répondre à toutes ces questions que les gens me posent souvent au cours de débats publics.

Tout d’abord, pour parler des dangers de domination de l’espèce humaine par l’intelligence artificielle, il ne fait aucun doute d’une part que, à terme, ça va prendre du temps, plusieurs décennies, peut-être siècles, les machines seront plus intelligentes que les humains dans tous les domaines où les humains ont des capacités ; ça, ça ne fait aucun doute. Ce ne sera pas l’intelligence humaine à cause de l’expérience du corps, etc., qui n’existera pas, en tout cas pas de la même façon, mais les machines seront plus intelligentes que les humains dans tout un tas de domaines. Maintenant, ce n’est pas parce qu’on est intelligent qu’on veut dominer. La volonté de dominer chez l’humanité, d’ailleurs, n’est pas corrélée à l’intelligence du tout ; ce ne sont pas les plus intelligents d’entre nous qui deviennent des chefs en général, on a beaucoup d’exemples de ce type sur la scène politique internationale.

Ali Baddou : Dit celui qui habite aux États-Unis !

Yann Le Cun : Par exemple. C’est plus lié à la testostérone et, en fait, c’est le résultat de la volonté de dominance dans l’humanité et le fait que les humains, l’espèce humaine est une espèce sociale dans laquelle on a besoin d’influencer nos semblables pour survivre. Et puis il y a des relations de dominance, soumission hiérarchique dans la société humaine, comme il y en a chez les babouins, chez les chimpanzés, tout ça est déterminé à l’évolution. Ce n’est pas lié à l’intelligence, c’est lié à la structure sociale que l’évolution nous a donnée, si vous voulez.

Ali Baddou : Natacha Polony.

Natacha Polony : Justement, les êtres humains, contrairement aux babouins, enfin dans la mesure de mes connaissances, ont inventé un truc pour contrer ça, ça s’appelle la démocratie. Ils ont estimé que pour essayer de limiter l’impact éthique de l’appétit de domination de certains il fallait essayer de faire en sorte qu’il y ait une délibération collective.

Yann Le Cun : Absolument.

Natacha Polony : Or, tout ce qui est en train de se passer actuellement autour de l’intelligence artificielle échappe, d’une certain façon, à cette délibération collective. Même si vous expliquez que c’est contributif, etc., de fait c’est le fait de grandes entreprises qui sont des monopoles privés et qui échappent totalement à tout questionnement collectif sur la légitimité de tel type d’avancée, sur la question de savoir à partir de quel moment il faut s’obliger à ne pas chercher dans cette direction-là ou ce genre de choses.

Ali Baddou : Yann Le Cun.

Yann Le Cun : Oui. Ce sont des questions vraiment très importantes qui ne sont pas directement liées à l’intelligence artificielle, qui sont liées, en fait, aux nouvelles technologies de communication. Toute nouvelle technologie de communication a eu des effets positifs et quelquefois des effets pervers qui n’ont pas été anticipés. C’est vrai pour l’imprimerie. L’imprimerie, par exemple, a permis de diffuser au 18e siècle les écrits du siècle des Lumières, mais aussi au 15e et au 16e siècles, les écrits de Luther et Calvin qui ont causé deux siècles de persécutions.

Natacha Polony : De guerres de religion.

Yann Le Cun : Et de guerres de religion.

Ali Baddou : Les protestants vont être révoltés par votre vision de l’histoire. Je referme la parenthèse.

Yann Le Cun : Je suis complètement athée et rationaliste, donc je ne prends pas parti en ce qui concerne la religion, mais personne ne dira que l’invention de l’imprimerie était une mauvaise chose, globalement, pour l’humanité, mais il y a des effets pervers même pour les choses…

Ali Baddou : C’est à ça qu’il faut comparer ?

Yann Le Cun : Non, ce n’est pas à ça qu’il faut comparer. Pareil pour l’invention de la radio, la radio a permis l’émergence du nazisme en Europe, on a fini par s’en protéger, etc. Toute technologie de communication a des effets positifs et des effets pervers. La question c’est comment limiter les effets pervers tout en maximisant les effets positifs ? L’avantage des réseaux sociaux c’est qu’ils donnent une voix à tout le monde. D’un point de vue fondamental, en fait, ils facilitent la démocratie. Maintenant la façon d’être exploités…

Ali Baddou : Mais, et vous le savez parce que vous travaillez sur Facebook qui est un espace d’expression pour deux milliards de personnes à travers le monde.

Yann Le Cun : Deux milliards sept, même.

Ali Baddou : Deux milliards sept, ça ne cesse donc d’augmenter ! Il y a par exemple la question des contenus haineux, supprimés ou non par Facebook dès qu’ils sont mis en circulation. Là, pour le coup, l’intelligence artificielle intervient puisqu’il faut les détecter immédiatement sinon automatiquement. C’est une vraie responsabilité.

Yann Le Cun : Absolument. C’est une vraie responsabilité.

Ali Baddou : Donc on n’est pas exactement dans le même cas que le cas de l’imprimeur ou de celui qui est un diffuseur radio, par exemple.

Yann Le Cun : Vous savez qu’au début de l’imprimerie on ne pouvait pas imprimer et distribuer un livre en France sans avoir un sceau du roi en fait, donc c’était extrêmement contrôlé aussi.

Natacha Polony : Mais il n’y avait pas d’algorithmes qui dictaient, qui faisaient remonter telle ou telle donnée par rapport aux autres.

Yann Le Cun : OK ! Ce qu’il faut vous dire c’est que les gouvernements autoritaires, quand ils ont peur de leur population, suppriment Facebook. Ça vous indique le pouvoir de Facebook pour la démocratie.

Natacha Polony : Il y en a en effet quelque chose qui est de l’ordre la nouvelle agora, mais !

Yann Le Cun : Le Printemps arabe, par exemple, a été permis par Facebook.

Ali Baddou : Et Twitter et c’est vrai, par les réseaux sociaux.

Yann Le Cun : Et Twitter, etc. Par ailleurs, effectivement, ces plateformes sont quelquefois utilisées par les gouvernements pour attiser des tensions ethniques comme on a vu au Myanmar par exemple ou à d’autres endroits, donc il faut se protéger contre ces choses-là.

Maintenant, pour la modération de contenus, encore une fois je parle de choses qui ne sont pas ma spécialité, sur lesquelles je ne travaille pas.

Ali Baddou : Oui, mais c’est intéressant parce que ce sont des questions que vous vous êtes forcément posées comme nous, comme citoyen concerné et connaissant le sujet.

Yann Le Cun : Absolument. Comme citoyen. Exactement. Donc comment définir un contenu haineux ? Mark Zuckerberg, l’année dernière, a fait un appel aux gouvernements du monde en disant « dites-nous, parce qu’on ne se sent pas comme ayant la légitimité pour prendre ce genre de décision, donc dites-nous ». Il y a eu un silence total sauf du gouvernement Macron. Le gouvernement Macron a été le seul à répondre. Il y a eu une grande discussion entre Facebook et le gouvernement Macron sur comment définir le contenu haineux pour ériger des règles claires : quels contenus on garde, quels contenus on élimine, etc. Ça c’est pour les contenus haineux. Il y a la propagande terroriste, il y a la pédophilie, les contenus pornographiques, etc., le harcèlement, donc il y a tout un tas de contenus, en fait, qui doivent être supprimés plus ou moins automatiquement ; ce n’est jamais parfait. La raison étant qu’on utilise ces systèmes qui sont entraînés et qui ont toujours un certain taux de faux positifs et de faux négatifs, donc ils vont laisser passer des choses qu’ils ne devraient pas laisser passer et, par ailleurs, ils vont supprimer, une fois de temps en temps, des choses qu’ils ne devraient pas supprimer et les gens, évidemment, ne sont pas contents. Ce qu’il faut c’est une procédure d’appel pour rétablir ces contenus. Il y a eu par exemple des ratés.

Ali Baddou : Le grand raté qu’on a tous en tête c’est la vidéo de la tuerie de Christchurch qui a été diffusée pendant 17 minutes sur Facebook, en l’occurrence, question sur laquelle vous revenez dans votre livre ; c’est l’un des exemples de ratés.

Yann Le Cun : En fait, technologiquement il est extrêmement compliqué de filtrer des vidéos qui sont faites en live, comme ça, parce qu’il faut qu’il y ait des systèmes automatiques qui reconnaissent le caractère violent, propagandiste, etc., de ces vidéos en temps réel, ce qui extrêmement compliqué. Pour le cas particulier d’une tuerie, d’un massacre, heureusement on n’a pas beaucoup de données d’entraînement pour entraîner nos systèmes de classification. Il n’y a pas beaucoup d’exemples de tueries par vidéo qu’on peut utiliser pour entraîner nos systèmes. Comme je l’ai dit précédemment il faut des milliers d’exemples et on n’a pas des milliers d’exemples. Par ailleurs il y a des vidés qui sont très similaires, des jeux vidéo, des films d’Hollywood dans lesquels il y a des massacres et qui sont tout à fait légitimes, quoi qu’on en pense.

Ali Baddou : Gilles Finchelstein.

Gilles Finchelstein : Parmi les autres risques que l’on évoque régulièrement c’est celui de créer une société de surveillance. Vous avez dit tout à l’heure que la machine sera plus intelligente que l’homme dans tous les domaines, mais vous dites aussi qu’aujourd’hui on en est loin, qu’elle n’a pas de bon sens, qu’elle est incapable de raisonner et que ses capacités intellectuelles sont plus proches de la souris que de l’être humain et donc, je vous cite, « s’il y a une catastrophe, elle ne pourra être imputée qu’à l’homme ». Est-ce qu’on ne donne pas, avec ces outils, justement la possibilité à l’homme d’exercer ses desseins les plus noirs ? Vous parlez des enceintes connectées en disant qu’elles sont en écoute en continu, qu’elles ont donc la capacité de surveiller toutes les conversations. Vous évoquez l’usage, notamment par les Chinois, de la reconnaissance faciale, donc là on est vraiment sur l’intelligence artificielle et ce sur quoi vous avez travaillé et vous avez contribué à faire des progrès considérables. Est-ce que là on ne donne pas, dans une période historique qui est particulièrement compliquée, à l’homme la capacité d’aller très loin dans la société de surveillance ?

Ali Baddou : Yann Le Cun.

Yann Le Cun : Ce qui nous protège des mauvais effets de la technologie, ce n’est pas seulement l’intelligence artificielle, ce sont les forces de nos institutions démocratiques. En fait, les utilisations un peu de dérive sécuritaire de l’IA, pour l’instant, sont dans des pays plutôt autoritaires dans lesquels, justement, il n’y a pas ces processus démocratiques. Si l’IA ou toute autre technologie, en fait, envahit notre vie, les gens ne vont pas l’accepter, vont mettre en place des élus qui vont protéger leur vie privée. On l’a vu, par exemple, en Europe avec le RGPD [Réglement général sur la protection des données]. Facebook, par exemple, a adopté les règles du RPGD mondialement même si la loi ne s’applique qu’en Europe, disant que c’était finalement une bonne idée.

En fait, il faut défendre les institutions démocratiques. La démocratie libérale a de gros avantages de ce côté-là – libérale au sens américain du terme, pas au sens économique du terme – et dans tous les cas, au cours de l’histoire, c’est le processus démocratique qui nous a protégé des dérives.

Ali Baddou : Natacha.

Natacha Polony : Oui, mais le processus démocratique n’est-il pas en partie entravé par ce qu’on évoquait tout à l’heure, la question du monopole ? Y a-t-il véritablement libéralisme quand il y a un monopole et un monopole privé ? C’est-à-dire que dans la mesure où Facebook ou Google ont pour but, tout de même, de gagner de l’argent, ce qui est le principe pour une entreprise, est-ce que ça n’aboutit pas à un glissement ? Par exemple dans le cas de Cambridge Analytica ou dans d’autres cas de ce genre-là, est-ce que ce n’est pas le fait qu’une entreprise telle que Facebook soit guidée par le besoin d’utiliser les données pour faire de l’argent qui aboutit à une dérive ?

Ali Baddou : Yann Le Cun.

Yann Le Cun : Je vais vous surprendre, je vais vous dire que le but aussi bien de Google que de Facebook n’est pas de faire l’argent.

Ali Baddou : Sérieusement !

Yann Le Cun : Sérieusement

Natacha Polony : Nous croyons à la philanthropie, mais il y a tout de même des limites !

Yann Le Cun : Le but de Google, d’ailleurs leur moto c’est d’organiser l’information du monde ; le but de Facebook c’est de connecter les gens. Maintenant, évidemment, on ne peut pas faire ça sans argent, donc il faut un moyen de financer cet effort. Mais si le but d’une entreprise est de gagner de l’argent, elle ne sert pas ses utilisateurs. Il faut bien voir que la motivation première de la compagnie, et c’est très clair quand on travaille dans cette entreprise, c’est de connecter les gens entre eux, d’avoir un effet positif. Il y a énormément d’effort qui est a passé à Facebook, pas pour détruire la démocratie, pour protéger la démocratie. Il y a un nombre phénoménal de personnes employées par Facebook dont le seul but, en fait, est de protéger la démocratie, d’empêcher, par exemple, des conflits ethniques qui sont véhiculés. Il y a des ratés, toujours, mais justement c’est ce qui permet ce contrôle.

Maintenant, Facebook est très conscient d’être une plateforme très importante de communication et Facebook ne veut pas s’ériger comme le dépositaire de la vérité. On demande à Facebook « supprimez cette publicité mensongère » qui est une publicité par exemple politique d’un candidat, Facebook ne se sent pas, ne se voit pas comme ayant la légitimité ou le droit de prendre ce genre de décision pour les gens. Ça c’est Facebook.

Très récemment Mark Zuckerberg, dans un discours qui date de quelques jours à la Goergestown University, a dit : « On a demandé aux gouvernements de nous donner des recommandations, les gouvernements n’ont rien fait. Donc ce qu’on va faire, on va mettre en place un conseil indépendant de Facebook — c’est financé par Facebook, Facebook met de l’argent dans une banque sans pouvoir y toucher — et on va demander à ce conseil d’ériger des règles de contenus et les décisions que prendra ce conseil seront obligatoires à suivre pour Facebook ». Donc c’est un système de gouvernement, si vous voulez, de Facebook, en fait qui est créé par un vide des vrais gouvernements, qui ne répondent pas.

Ali Baddou : Il reste quelques minutes. Rapidement Gilles.

Gilles Finchelstein : Après les élections de 2016, Facebook a réagi. La création de ce conseil indépendant est une de ses réactions. Une autre de ses réactions a été de vouloir favoriser, justement pour connecter les gens comme vous l’avez dit, les groupes, c’est-à-dire des réseaux de solidarité locale. Or, ce dont on s’est aperçu au moment du mouvement des Gilets jaunes chez nous c’est que un des effets de ces groupes a été que ceux qui étaient inscrits sur les groupes Facebook n’avaient plus, comme réalité, que les groupes Facebook ; qu’ils avaient connectées certaines personnes, mais ils en avaient déconnectées aussi beaucoup. Il y a eu un espace public, des espaces publics qui étaient extrêmement séparés. Donc ça ce n’est pas nécessairement une mauvaise de Facebook mais ça peut être un effet pervers. Est-ce qu’il y a des réflexions là-dessus ? Est-ce que ce que l’on a vécu en France a donné à réfléchir ailleurs ?

Ali Baddou : Constamment. Yann Le Cun.

Yann Le Cun : Constamment. Ce genre d’effet. Il y a un groupe entier à Facebook qui s’appelle Core Data Science, qui est entièrement dédié, en fait, à mesurer l’impact sur la société et sur la vie des gens de l’utilisation du service. Quelquefois il y a des réponses simples : supprimer la propagande terroriste c’est fait de manière très efficace avec des systèmes d’IA. On doit se reposer sur des systèmes d’IA parce que le volume d’informations est telle qu’on ne peut pas le faire manuellement, bien qu’il y ait, en fait, entre 15 et 20 mille personnes employées par Facebook qui font de la modération de contenus manuelle, mais il faut que ces gens parlent toutes les langues du monde qui sont utilisées sur Facebook ; ce sont des milliers de langues.

Ali Baddou : Et puis ils sont 20 000 pour 2 milliards 700 millions d’utilisateurs !

Yann Le Cun : Qui postent des milliards et des milliards de posts, donc ce n’est pas possible. Par exemple, si vous voulez distribuer de la propagande néonazie en Europe, vous n’écrivez pas un post néonazi parce qu’il va être supprimé tout de suite par des systèmes automatiques, ce que vous faites c’est vous faites une image et vous tapez le texte dans l’image. Donc il faut maintenant un système de reconnaissance d’image qui lise le texte pour détecter que c’est de la propagande néonazie pour l’enlever. Ce que font maintenant les gens qui veulent distribuer ce genre d’information, ils rendent le texte difficile à lire pour les machines, donc c’est une espèce de jeu de chat et de la souris.

Mais ce genre de réflexion à Facebook — comment défendre la démocratie, quel type d’information doit être véhiculé, quelles pages doit-on garder ou supprimer — ce sont des questions qu’on se pose journellement.

Ali Baddou : Natacha Polony.

Natacha Polony : Est-ce que le risque, enfin c’est d’ailleurs celui qui a été soulevé au moment de la discussion sur la loi Avia sur les propos haineux sur Internet.

Ali Baddou : Du nom de Laetitia Avia, la députée LREM qui porte le projet.

Natacha Polony : Vous expliquez que Facebook ne se veut pas détenteur de la vérité, mais, par principe de précaution, est-ce que les plateformes ne risquent pas de supprimer des contenus dès qu’il risque d’y avoir un débat social sur tel contenu ? C’est-à-dire en gros, quand il y a des associations particulièrement virulentes on sait très bien qu’elles font monter des discussions sur la laïcité, sur la critique de telle ou telle religion, on ne risque pas de se retrouver face à une entreprise qui va garantir avant tout sa sécurité ?

Ali Baddou : Yann Le Cun.

Yann Le Cun : Le principe de précaution est, en fait, celui qui consiste à ne pas interférer, c’est-à-dire laisser les contenus passer. Il y a généralement des processus de réflexion qui sont assez longs pour décider de supprimer. Par exemple, il y a eu une décision de Facebook, il y a quelques mois, de supprimer des groupes qui étaient très suivis aux États-Unis contre les vaccins, des groupes qui disaient que les vaccins causent l’autisme, etc. – ce qui est factuellement faux, c’est prouvé par des études scientifiques très nombreuses – et qui ont un effet très délétère sur la société puisque ça contribue à des épidémies qui, par ailleurs, n’existeraient pas. Ça ce sont des décisions qui ne sont pas prises à la légère surtout pour des groupes qui sont très suivis. C’est très difficile à faire quand les groupes ou les participants appartiennent par exemple à des gouvernements, mais ça a dû être fait à quelques occasions, dans le cas de gouvernements qui appelaient à des massacres. On est obligé de prendre des mesures simplement pour des raisons humanitaires. Ce sont de questions qui sont vraiment très compliquées. Facebook se fait attaquer de tous les côtés.

Ali Baddou : Facebook comme les autres GAFA d’ailleurs.

Yann Le Cun : Comme les autres GAFA, surtout les réseaux sociaux ou Google. D’une part des gens qui disent « vous ne faites pas assez de censure » et, d’autre part, des gens qui disent « vous en faites trop ». Souvent ce sont les mêmes gens mais pas pour le même genre de contenu.

Ali Baddou : Ce qui est assez fascinant c’est le nombre de questions que pose cette révolution technologique en cours, vous revenez sur plusieurs d’entre elles, et on n’a pas eu le temps d’en parler, mais notamment la dimension sociale puisque vous dites que oui, l’intelligence artificielle aura des conséquences sur l’emploi à n’en pas douter. Vous affrontez des questions très nombreuses qui ont trait à nos inquiétudes, nos inquiétudes légitimes, aux fantasmes aussi parfois. Vous revenez sur le grand film qui vous a longtemps inspiré depuis votre adolescence 2001, l’Odyssée de l’espace qui, pour le coup, donne vraiment une version sombre de ce que peut faire une machine avec Hal, le robot tueur. C’est passionnant en tout cas de vous entendre.

Merci infiniment, Yann Le Cun, d’avoir accepté de débattre aujourd’hui dans Le Grand Face-à-face. Quand la machine apprendest publié chez Odile Jacob.

Natacha et Gilles je vous donne rendez-vous samedi prochain. Merci à Mathilde Khlat qui a préparé cette émission…