Merci beaucoup, ravie d’être là.

La conférence s’intitule « Numérique, chaînes de dépendance, des enjeux géopolitiques et environnementaux ». C’est assez large mais au final, vous allez voir, ça s’imbrique assez bien.

Mon champ de recherche concerne la théorisation de la mise en dépendance, globalement, comprenant les phénomènes de territorialisation comme enjeu de pouvoir, notamment la territorialisation des infrastructures, mais pas seulement. Dans mon travail, je n’ai pas seulement un côté recherche, j’essaie aussi d’agir sur le terrain. Moi-même, je suis dans le secteur du numérique depuis 2009, en étant passée par un parcours de dev fron-end avant de devenir chef de produit puis chargée de recherche utilisateur aujourd’hui, à la Direction interministérielle du numérique [1]. À côté de ce travail de recherche, forcément, j’ai envie de faire des propositions concrètes, donc d’associer le penser et le faire d’une certaine manière.

Je vous parlerai aussi beaucoup, pendant ce moment, de l’objet Big Tech, pour la simple et bonne raison que dans mon domaine de recherche, dans la théorisation de la mise en dépendance, ce sont des objets très intéressants, notamment parce qu’ils mettent en place des stratégies de mise en dépendance, et que ces stratégies de mise en dépendance ont des conséquences réelles sur l’équilibre économique, politique et social et qu’ils ont une influence sur les enjeux de pouvoir et de capacité de négociation des acteurs.

Donc en trois parties.

La première partie, je vais d’abord vous parler des chaînes de dépendance et de leurs relations aux territoires.

Dans la deuxième partie, des risques géopolitiques et environnementaux que ces chaînes de dépendance et les stratégies de mise en dépendance ont sur les pays, sur les entreprises et sur les citoyens.

Et ensuite nous définirons ensemble, en quelque sorte, une stratégie industrielle en voyant quelques points, on ne les verra pas tous mais on essaiera d’avoir quelques axes de réflexion là-dessus.

Chaînes de dépendance et Territoire

Quand on parle de chaînes de dépendance, on pourrait, évidemment, prendre plusieurs familles de chaînes de dépendance : la chaîne de dépendance industrielle, infrastructurelle, la chaîne de dépendance technique primaire, qu’on verra un petit peu aussi, la dépendance au marché — quand on dit que les entreprises sont dépendantes à leur marché, est-ce l’entreprise est dépendante à son marché ou le marché qui est dépendant à l’entreprise ? —, la dépendance aux usages et, de manière plus globale, les dépendances technologiques.

Dépendance industrielle

Concernant la dépendance industrielle, d’abord, ça va vous paraître très simple, mais petit rappel tout de même. Au final, quand on parle de dépendance industrielle, on peut d’abord parler des dépendances à l’intérieur du secteur industriel — donc intra-industrielles — qui vont être à la fois la chaîne logistique et la chaîne de production. Par exemple, dans le secteur du numérique, partant des matières premières, de l’exploitation de ces matières premières, de la création des composants techniques, des logiciels et des produits finis, qu’il s’agisse des produits logiciels ou des produits devices, des supports que nous utilisons au quotidien.

À côté de ces dépendances intra-industrielles, les dépendances inter-industrielles finalement augmentent, agrandissent les chaînes de dépendance pour prendre en compte les industries sœurs en quelque sorte : l’industrie du génie industriel qui permet, par exemple, de fabriquer les machines extrayant les minerais ou les machines lithographiques qui permettent de fabriquer les composants électroniques ; la production et le transport d’énergie ; l’industrie du transport en général, maritime pour beaucoup tant la distance entre les minerais et les usines de production de produits finis est grande ; évidemment l’industrie informatique qui, aujourd’hui, compte énormément d’acteurs en sous-traitance ; le commerce, etc.

Pour illustrer un petit peu les choses dans le cas, par exemple, d’acteurs industriels dans une chaîne comme celle des câbles sous-marins :

- dans les matières premières en général, l’industrie minière peut être utilisée pour le cuivre, l’aluminium et la silice utilisée dans les fibres optiques ;

- passant aux fabricants de câbles dont les grands leaders vont être, par exemple, ZTT [2], Brugg [3] et d’autres ; ZTT, société chinoise, est l’un des leaders dans la fabrication des câbles aujourd’hui ;

- les poseurs de câbles sous-marins ou les armateurs, c’est quelque chose qu’on connaît très bien, en France, avec Alcatel Submarine Networks [4]. On parle un peu moins d’Orange Marine [5] qui reste sous giron français, si on peut dire les choses comme ça ; SubCom LLC [6], Huawei Marine [7] qui prend de plus en plus en ampleur, et puis des armateurs comme Louis Dreyfus [8] par exemple, puisqu’en France, de ce côté-là, on est quand même assez bien pourvus en ingénierie marine, c’est l’un de nos points avantageux ;

- ensuite, bien sûr derrière, les exploitants : les entreprises de télécommunications pour les réseaux ou aujourd’hui, de plus en plus, les géants du numérique.

Quelque chose de très facile à utiliser pour montrer la dépendance entre l’industrie et les territoires, ça pourrait être de partir de la localisation des minerais qui nous permettrait de voir que les gisements sont partout sur la planète, mais tout de même de manière déséquilibrée, des gisements favorisant certains acteurs par rapport à d’autres.

Le cuivre est l’un des minerais que l’on retrouve un peu partout sur la planète. Là, je vous ai mis uniquement les gros gisements, c’est-à-dire ceux qui font vraiment la différence avec les petits gisements où là on tombe à 500, 200, 300 000 tonnes par an. On arrive avec des avantages clairement pour le Pérou et le Chili.

De même, dans leurs pays, il y a beaucoup de lithium ; je vous conseille un travail de recherche d’Audrey Serandour, chercheuse qui a beaucoup travaillé sur le triangle du lithium [9] en Amérique du sud : on va avoir des rapports de force intéressants en leur faveur sur ces deux minerais.

Les terres rares, où là on va avoir une prédominance de la Chine à la fois dans les gisements mais aussi dans les exploitants ; le Brésil — et on voit la différence —, j’ai mis les États-Unis parce qu’on voit quand même bien la différence dans les terres rares, notamment sur le fait qu’on peut trouver des terres rares un peu partout dans le monde, mais le problème c’est que selon le territoire évidemment, la qualité et la quantité ne sont pas les mêmes, ce qui bien sûr avantage certains acteurs.

Le cobalt est un cas vraiment exceptionnel. On va avoir des gisements de cobalt, en tout cas aujourd’hui, qui sont principalement extrait en République démocratique du Congo, sachant que la terre de gisement n’est pas celle de l’exploitant, puisque l’exploitant est en très grande majorité chinois.

Donc la dépendance industrielle, c’est une chose. On voit déjà la difficulté quand on aborde les sujets de souveraineté numérique : où s’arrête la souveraineté numérique ? À quel moment de la chaîne je considère que je dois être souverain dans ma souveraineté numérique ou pas, ou dépendant ?

Dépendance infrastructurelle et Territoire

Là, on rentre dans quelque chose de plus en plus intéressant à mon sens. On a certes une répartition inégale des réseaux et des infrastructures de données avec des configurations géographiques qui vont être avantageuses pour les uns, problématiques pour les autres. Ces configurations géographiques sont accentuées par les conditions climatiques qui, aujourd’hui, représentent un enjeu majeur, notamment pour l’installation des datacenters. Tout cela conduit à une inégale répartition des pouvoirs et des rapports de force, notamment des pouvoirs qui, aujourd’hui, sont détenus par des entreprises privées et qui ont fait de la territorialisation des infrastructures, de manière générale, un enjeu stratégique majeur mais aussi un enjeu de survie pour leur entreprise.

Avant de parler des entreprises qui impliquent le territoire, déjà, à la base, sur les infrastructures, il y a le fait, tout simplement, d’être dans un pays enclavé, c’est-à-dire qui n’a pas d’accès à la mer, à l’océan, et qui, du coup, se trouve dans l’impossibilité d’accéder aux câbles sous-marins par lesquels passent 98% de nos communications internet. Évidemment, ces pays pourront tout à fait bénéficier des réseaux satellitaires à orbite basse de Kuiper [10] ou Starlink [11], mais cela créera d’autres dépendances. La dépendance aux câbles sous-marins se transformera en dépendance aux satellites d’une manière ou d’une autre.

En Europe, ces pays vont être par exemple la Slovaquie, la Tchéquie, l’Autriche, la Suisse, le Luxembourg. Concernant la Suisse, ce qui est assez intéressant c’est que leur localisation en tant que pays enclavé a aussi des conséquences sur les performances de certaines pratiques, puisque, aujourd’hui, la place de marché suisse se trouve en concurrence, par exemple, avec la place de marché de Singapour dans le secteur du trading à haute fréquence, où le fait d’accéder, comme Singapour, directement aux câbles de fibre optique sous-marins a une importance sur les performances finales.

Donc c’est intéressant de voir comment le territoire, au final, a aussi une influence économique forte.

Les conditions climatiques, on va y revenir ensuite avec d’autres pays, mais commençons par les États-Unis, puisque pas mal de chercheurs ont commencé à travailler ces dernières années sur ce sujet-là, suite à de plus en plus de controverses au Texas, en Arizona, en Californie sur la consommation en eau. Les États-Unis sont un pays où il va y avoir de plus en plus de tension sur le territoire à cause de la sécheresse, et on voit que les datacenters ont, évidemment, une consommation exponentielle en termes de consommation d’eau et d’énergie.

Je sais ce qu’on peut me dire déjà à ce niveau-là : « Oui, mais aujourd’hui les performances des datacenters permettent de pallier… ». C’est vrai d’une certaine manière : les performances et l’innovation peuvent permettre de pallier un certain nombre d’excès de consommation en eau et en électricité. Néanmoins, il y a tout le poids de l’existant qui fonctionne majoritairement sur des énergies fossiles, par exemple, et qui va être assez consommateur en eau — on va revenir sur le calcul de la consommation en eau.

Partant de là, quand on parle de territorialisation des infrastructures comme enjeu de pouvoir, de quoi parle-t-on ?

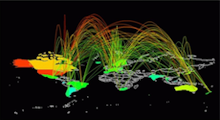

Il y a un cas que j’aime beaucoup, c’est celui des câbles sous-marins qui appartiennent tout ou partie aux Big Tech étasuniennes, même si on pourrait aussi parler de ceux qui appartiennent à Hengtong [12] et Huawei, côté chinois.

Ce que vous voyez sur la carte, dans le fond, ce sont les câbles sous-marins qui appartiennent déjà aux Big Tech. Quand je parle de Big Tech, je parle des GAFAM dans leur nouvelle version, c’est-à-dire des grandes sociétés multinationales qui aujourd’hui ne se limitent pas seulement à la communication et aux logiciels, mais sont allées sur le terrain des infrastructures, donc, sur des enjeux majeurs de géopolitique.

Concernant le nombre total de câbles dans le monde, on en a 436 connus ; on pourrait se dire « 436 connus, au final, si on regarde le nombre de câbles que possèdent les Big Tech, ce n’est pas grand-chose ! ». En fait, ils ont commencé à les construire simplement depuis six ans, depuis 2016. Donc c’est une évolution très rapide, ils ont les câbles les plus performants. Là, par exemple, Google a déjà 20 câbles en partie ou en totalité, sachant que Google est la seule entreprise qui possède à elle seule des câbles en entier, c’est-à-dire qu’elle a la capacité financière et, surtout, elle a ciblé ce secteur industriel pour construire, financer à elle seule la construction et la sécurisation, le management de ces câbles, ce qui est énorme.

Meta en possède en partie 12, Microsoft 5, et Amazon Web Services 5, sachant qu’Amazon, de toute façon, veut se développer au niveau infrastructurel sur la partie satellitaire. On pourrait se dire, en gros, que Google fait des câbles et Amazon des satellites, les deux étant au final liés, on va aussi voir pourquoi.

On va voir trois cas de territorialisation d’infrastructures. Je vais commencer par la France, ensuite l’Europe du Nord et enfin l’Afrique.

La France, pourquoi ? Parce qu’on a une configuration territoriale très intéressante due au fait qu’on a beaucoup de côtes, ce qui fait qu’on a pas mal de possibilités de connexion aux câbles. Nos premières connexions aux câbles ont été beaucoup avec le Royaume-Uni et puis, progressivement, on a développé des câbles à l’ouest et au sud, sachant qu’à l’ouest on va avoir des câbles connectés à d’autres pays d’Europe, et on va avoir quatre très gros câbles qui sont connectés aux États-Unis. Au sud, on va avoir tous les câbles qui connectent le continent africain et la France, et également ceux qui viennent d’Asie, comme le câble PEACE qui a été construit très récemment par Hengtong et Huawei et qui atterrit à Marseille. Mais ce n’est pas seulement pour alimenter la France, ça va être une porte d’entrée pour l’ensemble de l’Europe, les pays enclavés, mais aussi ceux qui n’ont pas beaucoup d’accès aux câbles et qui vont donc passer par les réseaux terrestres.

Ce qui est assez intéressant ensuite, c’est de voir comment ça s’est fait. Comme vous le savez peut-être, environ 33% de la totalité des datacenters sont localisés aux États-Unis, le reste étant éparpillé un peu partout dans le monde ; on a une concentration de datacenters. Ce n’est pas une bonne nouvelle pour les États-Unis vu les enjeux climatiques auxquels ils vont faire face de plus en plus. Du coup, la question de l’installation de serveurs qui, en plus, traitent des données d’autres pays devient un souci, notamment pour le citoyen américain à qui on demande, au Texas et en Arizona, de faire des efforts sur sa consommation en eau.

Progressivement, à la fois pour des raisons économiques mais aussi pour des questions stratégiques et environnementales, les grandes sociétés américaines veulent, en quelque sorte, exporter leur modèle ailleurs et s’étendre. Sur les quatre gros câbles connectés entre la France et les États-Unis, on voit deux gros câbles des Big Tech, Dunant [13] et Amitié [14], Dunant étant de Google et Amitié très majoritairement financé par Meta.

La manière dont ça s’est fait ? Sur notre territoire européen, ces Big Tech ont une stratégie de partenariat avec les entreprises des télécoms. Les entreprises des télécoms n’ont plus les moyens financiers, aujourd’hui, de financer la construction de nouveaux câbles parce que ce sont des investissements énormes ; par ailleurs, après les avoir construits, il faut aussi les gérer. Quelque part les entreprises de télécoms se disent qu’elles vont bénéficier de ces partenariats pour faire des économies, tout simplement.

Pour les Big Tech, c’est un renversement total au niveau historique des relations qu’ils avaient pu avoir avec les entreprises de télécoms, puisque jusqu’à présent, ils devaient négocier les prix d’usage du réseau, d’usage du trafic, avec les entreprises de télécoms. Aujourd’hui les choses se renversent puisque ce sont eux qui vont faire payer aux télécoms l’accès aux câbles, avec certes des accords qui se jouent dans ce fameux partenariat. En France, on a donc Orange qui a négocié à la fois avec Google et avec Meta pour la construction de ces câbles et pour avoir un certain nombre de privilèges à la fois sur les prix, sur l’usage et sur la gestion de la station d’atterrissement, ce qui est assez intéressant. La station d’atterrissement, qu’est-ce que c’est ? C’est ce qu’on va avoir sur la côte, à l’arrivée, dans les deux sens en fait. Chez nous, ça va rester l’acteur télécoms qui va gérer ces stations d’atterrissement.

Autre bénéfice pour les Big Tech, c’est qu’ils n’aiment pas gérer, et ça va se retrouver sur l’Afrique, la paperasse administrative et, dans un pays comme la France, c’est en plus assez compliqué. On va dire que ça les ennuie et, quelque part, ça leur permet de laisser la paperasse administrative aux locaux. Ce n’est pas une blague, c’est quelque chose que j’ai pu entendre à plusieurs reprises dans des échanges et entretiens.

À ce partenariat sur les câbles s’ajoutent, pour les Big tech, les fameux partenariats stratégiques dont on a beaucoup entendu parler ces dernières années dans l’industrie du cloud. Et du coup, pour l’acteur télécoms, le fait de devenir simple client limite sa capacité d’action sur la gouvernance des câbles, il a moins de possibilités de décider de l’avenir et de l’usage du câble. Par ailleurs, en faisant ces partenariats avec une multinationale puissante sur l’adoption du cloud, il participe, en fait, à l’expansion du cloud en Europe, de manière générale. Si je parle du niveau européen, c’est parce que, en effet, on a des partenariats dans toute l’Europe avec les Big Tech, que ce soit en Allemagne, Deutsche Telekom, Telefonica en Espagne, Telenet en Belgique, les télécoms italiens également. Les grosses entreprises de télécoms en Europe ont vraiment fait ces partenariats stratégiques au niveau du cloud.

Là où ça devient intéressant, c’est de voir que ça ne concerne pas seulement les Big Tech américaines, mais d’autres entreprises américaines comme les centres de données. Ce sont des entreprises dont on entend moins parler que les fameuses GAFAM, mais, au final, ce sont des leaders de marché également : Equinix [15], Digital Realty qu’on peut aussi trouver sous le nom d’Interxion [16] puisqu’ils les ont achetés, NTT [17], qui est moins présent chez nous, et qui sont les détenteurs majoritaires de ces fameux 33% de datacenters aux États-Unis et qui se développent fortement en Europe. Alors fortement !, on n’a pas tous les jours un datacenter qui s’ouvre en Europe, néanmoins vous voyez des signes : Equinix a ouvert son fameux centres de données justement à côté du câble Amitié, c’est assez pratique d’avoir une connexion pratiquement directe au câble à Bordeaux alors que jusqu’à présent Equinix avait ses dizaines de datacenters centralisés à Paris, en France.

Au niveau de l’Europe du Nord, on a de plus en plus de datacenters qui sont construits par Digital Realty/Interxion.

On voit que les Big Tech font des partenariats, évidemment, avec ces entreprises leaders de datacenters. Qui a le dessus sur qui ? On pourrait se dire que c’est le datacenter qui a le dessus : ils ont l’infrastructure, donc quelque part les Big Tech sont dépendants de leur infrastructure ; au-delà de leurs propres serveurs, ils peuvent être dépendants de leur infrastructure. En fait non, pas tant que ça puisque Equinix et Digital Realty, pour se développer de cette manière-là, ciblent beaucoup ce qu’ils appellent le cloud OnRamp, en fait des solutions de cloud partagé ; c’est la possibilité, pour un acteur, d’accéder aux différents services de cloud, et c’est une proposition qu’ils vendent comme proposition commerciale forte et qui reste un argument très fort, très puissant, pour convaincre les décideurs européens aujourd’hui. En fait c’est un accord win-win, en quelque sorte, qui va plutôt en faveur des Big Tech puisque ça les aide à étendre leurs technologies logicielles.

Pour ceux qui connaissent, c’est un schéma relativement simple, mais ça permet quand même de voir un petit peu l’échiquier des pouvoirs, en tout cas des acteurs. Au départ on a l’informatique en plateforme, ce qu’on appelle le cloud computing. Ce sont plutôt des systèmes centralisés à distance et qui, petit à petit, ont été régionalisés. On peut trouver sur tous les sites des entreprises la fameuse régionalisation de services, sachant que cette régionalisation n’est pas complètement détaillée, on ne sait jamais exactement ce qui régionalisé ou pas.

Ensuite, le développement du edge computing qui est l’informatique en périphérie. Pour cette informatique en périphérie, les Big Tech ont développé des sous-services, enfin ce ne sont pas des sous-services, ce sont des services très importants, mais disons des branches comme Amazon Web Services Wavelength, Google Cloud Anthos, Microsoft Azure Edge Zone, avec lesquels ils travaillent plus particulièrement justement avec le secteur des télécoms. Ils ne sont pas seuls ; il y a évidemment des concurrents comme Mobile Edge qui fait également des choses intéressantes.

Ensuite on va avoir, en bout de file, les socles physiques de périphérie qui, via les partenariats et les nouveaux rapports de force, se trouvent dépendants de l’ensemble de l’informatique en plateforme. On peut se dire, en tout cas pour certains aspects, je ne dis pas pour tous, qu’il y a des dépendances qui se font à ce niveau-là et surtout des rapports de force entre les différents acteurs depuis que les Big Tech ont pris, comme cela, de l’importance sur le domaine infrastructurel. Donc les réseaux télécoms mais également les réseaux appliqués comme Cisco, Intel, Dell, les centres de données comme on a pu le voir, Equinix, Edge Connect, Interxion, plutôt Digital Realty. On a donc en fait, aujourd’hui, quelque chose qui est de l’ordre de l’infrastructure territorialisée qui tente, aussi, de convaincre de la territorialisation des briques logicielles.

On reviendra sur le logiciel.

L’Europe du Nord, réchauffement climatique et positionnement géostratégique

Tout d’abord l’Europe du Nord, pourquoi parle-t-on de l’Europe du Nord ? Pour revenir sur le réchauffement climatique et l’importance qu’il va avoir à l’avenir.

Depuis quelques années, à côté du développement des câbles, des datacenters un peu partout en Europe, il y a un développement particulièrement important des centres de données en Europe du Nord. Ces chantiers sont très bien accueillis par ces pays-là ; ils ne sont pas du tout contre, au contraire, ils le voient comme une opportunité économique majeure. On peut voir sur la photo le centre de données Facebook à Odense. Il se trouve que la semaine dernière j’étais au Danemark et j’ai pu voir des choses assez intéressantes sur place mais aussi la place des énergies renouvelables et la manière de voir la transformation numérique et les Big Tech au Danemark. Pour l’instant, il y a assez peu de dimension critique. On est vraiment dans cette idée que la transformation numérique va tous nous sauver, l’innovation va permettre de pallier les problèmes écologiques du numérique, etc.

La particularité de ce centre de données à Odense, c’est que Facebook réutilise la chaleur de son centre de données pour chauffer la ville d’Odense, qui est d’ailleurs une charmante ville. C’est assez connu, il y a quand même quelques petites controverses, j’ai entendu des discours — je ne sais pas s’ils sont vrais, s’ils sont dignes de foi — selon lesquels ce centre de données appartiendrait en réalité à la NSA. Il y a aussi beaucoup de paranoïa derrière ça, avec peu de faits concrets, même si, évidemment, on sait quelles sont les législations américaines et pourquoi elles créent de la crainte.

Donc on a un produit Facebook, comme ça, au Danemark, et puis on a un certain nombre de datacenters qui appartiennent à Google ; Apple avait historiquement un datacenter. Sinon pour l’instant, quand on regarde le nombre important de datacenters que le Danemark a sur son territoire, on voit qu’il est assez bien pourvus en datacenters danois. Le problème ce sont, comme partout en Europe, les datacenters associés au cloud.

La consommation d’eau est le gros point positif des pays d’Europe du nord ; quand on regarde les prévisions de sécheresse à + 1,5, + 2, + 3 degrés, on comprend assez bien. Le problème pour les États-Unis, tout ce qui est rouge, ce sont des taux de sécheresse extrême, en tout cas pas tenables. À trois degrés on est dans une situation assez catastrophique dans la plupart des États.

En Europe on prend quand même pas mal aussi, mais, selon les prévisions, les pays de l’Europe du Nord seraient quand même assez protégés de ce réchauffement, de ces périodes de sécheresse. Ça ne veut pas dire qu’ils n’en auront pas mais ils seront moins face à ce problème-là. En revanche, ils auront le problème de la montée des eaux, leurs pays étant très souvent au niveau de la mer, ils vont perdre un petit peu de territoire, c’est notamment le cas pour les Pays-Bas. Si vous regardez les cartes, ça va être assez compliqué.

L’Europe du Nord est un eldorado pour la simple et bonne raison qu’elle a beaucoup d’eau et moins de problèmes de sécheresse.

Aujourd’hui on fait beaucoup de discours sur le fait que l’innovation va permettre de réduire la consommation d’eau des datacenters, mais le calcul de la consommation de l’eau ne prend pas du tout en compte, aujourd’hui, l’usage indirect de l’eau. Quand Google, Amazon ou même des sociétés européennes font le compte de la consommation d’eau, elles ne prennent en compte que le WUE [Water Usage Effectiveness] qui est, en fait, l’usage direct du datacenter pour refroidir ses infrastructures. Elles ne prennent pas en compte l’eau qui est utilisée pour produire l’énergie qu’elles utilisent. Selon un rapport américain, c’est très intéressant, l’usage indirect de l’eau représenterait à peu près 85/90% de la consommation globale en eau. Ça reste évidemment un chiffre à modérer puisque cela va dépendre de la source d’énergie. On sait très bien que les énergies fossiles consomment, par exemple, bien plus que les énergies renouvelables. En termes de prélèvement d’eau, on est à peu près à 230 milliards de mètres cubes au niveau mondial pour les énergies fossiles, on serait à 113-115 milliards de mètres cubes de prélèvement pour l’énergie nucléaire, et on serait à 10 milliards de mètres cubes en prélèvement pour les énergies renouvelables.

Évidemment, ceux qui connaissent me diront « attention, ça c’est le prélèvement, ce n’est pas la consommation ». Il y a effectivement un gros écart entre prélèvement et consommation. La consommation du nucléaire, par exemple, par rapport au prélèvement, donc 115 milliards de mètres cube au niveau du prélèvement, ça va être 4 milliards de consommation, finalement. On peut se dire « OK, bon ». Mais le prélèvement est très important : ce qu’on va prélever à la terre à un moment donné, c’est ce qu’on ne va pas donner à d’autres activités, comme l’activité agricole ou même les usages courants. Donc en période de sécheresse, ça a son importance.

Dans un pays comme la France, pour vous donner un ordre d’idée, 60% des prélèvements en eau sont dédiés à l’énergie nucléaire. Donc augmenter les chantiers de datacenters et augmenter le nucléaire, pourquoi pas, mais, à un moment donné, ça va finir par coincer.

Aujourd’hui on a donc besoin de clarifier ces notions de calcul — comment calculer la consommation en eau ? —, on a besoin d’améliorer les technologies de refroidissement, d’améliorer la consommation en énergie, mais tout cela, au final, aura toujours un impact sur le terrain. On commence, d’ailleurs, à voir pas mal de controverses en Europe et en Europe du Nord, en Suède par exemple où ils se sont rendu compte qu’il y avait énormément de consommation en eau et qu’il fallait, à un moment donné, faire un moratoire qui n’a pas du tout été pris en compte. De même en Irlande, pas plus tard que l’année dernière, ils se sont rendu compte qu’il y avait quand même 11 alertes de blackout par an. C’est très compliqué pour ces pays-là, sachant qu’ils ont eu des hausses de construction de datacenters en très peu de temps. Du coup, dans certains territoires, ils se sont retrouvés face à des situations où l’eau a manqué pour d’autres industries, avec également des restrictions pour les citoyens.

On voit que ces controverses qui, au départ, étaient présentes plutôt aux États-Unis, sont en train de venir en Europe dans les territoires qui ont construit beaucoup de datacenters ces dernières années.

Par rapport à l’Europe du Nord, les prévisions climatiques jouent, évidemment, mais également le développement des énergies renouvelables. La Suède, par exemple, utilise 60% d’énergies renouvelables ; 40% pour la Lettonie et l’Autriche ; c’est assez énorme par rapport à la France : on est à 18%. Il faudrait, déjà, avoir une meilleure attitude face au développement des énergies renouvelables, c’est évident, et c’est devenu un argument commercial pour ces pays pour accueillir les grands datacenters.

En revanche, on voit que ces pays — c’est Eurostat qui nous le dit, pas plus tard que l’année dernière, cette étude est excellente même s’il y a des lacunes — sont, dans le même temps, ceux qui ont le plus de dépendance, une dépendance très forte aux technologies de cloud, dont les leaders, comme vous le savez, sont les Big Tech. On voit que la Suède, le Danemark, la Finlande, les Pays-Bas, tous ces pays du Nord qui accueillent aujourd’hui de plus en plus de datacenters et vont probablement devenir le territoire des datacenters en Europe sur les dix prochaines années, dans le même temps eux-mêmes sont très dépendants aux technologies cloud qu’il ne maîtrisent pas, dans le sens où il ne les ont pas fabriquées, ils ne les designent pas et n’ont donc pas de pouvoir de négociation vis-à-vis des acteurs qui construisent des datacenters sur leur territoire et puisent leur eau et énergie. Ils vont donc probablement se retrouver, à un moment donné, face à des questions de gouvernance, face à des problèmes politiques, face à des problèmes de négociation avec des multinationales qui puisent sur leur territoire, suite à des contrats faits avec les autorités locales, et qui, en plus de cela, rendent dépendantes une partie de leurs entreprises et de leurs services publics numériques. C’est le souci.

Le continent africain et le néo-colonialisme technologique

Passons ensuite sur le continent africain. Pour quelle raison je fais ce grand écart ? Avec le continent africain on n’est pas du tout dans la même situation. Autant, en Europe, on a quand même une forte transformation numérique, pas forcément bien menée puisqu’on se rend compte qu’on a énormément de dépendances en Europe, le continent africain, lui, est en plein boom, en pleine transformation numérique.

Comment cela se passe-t-il pour les Big Tech lors de leur développement en Afrique ? C’est, encore une fois, un changement historique qui revient aux changements qu’on a pu voir, tout à l’heure, entre les télécoms et les Big Tech. du modèle traditionnel. Des années 2000 aux années 2012, les câbles sous-marins étaient détenus par des larges consortiums d’entreprises de télécoms : par exemple SAT3 [18] représente 23 acteurs qui négocient ensemble et qui paient ensemble des câbles ; EASSy [19] représente 19 acteurs, WACS [20], 10 acteurs et ACE [21], 20 acteurs. On voit qu’on a des consortiums assez larges, ce qui permet de partager la décision et complexifie les échanges, évidemment, mais on a au moins la possibilité de se faire entendre, d’une certaine manière, dans de larges consortiums. On pourrait les critiquer, évidemment. Pour ceux qui connaissent, on sait que les acteurs les plus puissants sont ceux qui ont le plus d’argent dans ces consortiums, c’est toujours la même chose mais, au moins, il y a quand même une possibilité de parole.

Aujourd’hui, comme on est sur un nouveau modèle avec soit de tout petits consortiums, soit avec des entreprises qui sont capables et qui veulent avoir le contrôle de l’ensemble de leurs câbles, on va avoir :

- le câble Equiano, qui est en train de prendre toute la côte ouest du continent africain, qui pour l’instant est relié seulement à quelques pays comme le Nigeria et la République démocratique du Congo dont on parlait tout à l’heure pour le cobalt ;

- 2Africa, détenu en majorité par Facebook mais aussi par d’autres acteurs dont des acteurs télécoms, un câble qui fait complètement le tour de tout le continent ;

- et PEACE qui fonctionne sur un autre modèle, le modèle chinois : ce n’est pas un financement par les entreprises mais par les banques nationales. Il est donc détenu administrativement par Huawei et Hengtong. On voit d’ailleurs le câble qui arrive à l’est de l’Afrique, mais on le voit aussi remonter et il vient se connecter à Marseille par ici.

Ce qui est très intéressant, quand on étudie les dépendances infrastructurelles ensuite, c’est de définir des seuils. Dans le cas de l’Afrique, on pourrait se dire que l’un des critères de ces seuils c’est tout simplement le nombre de câbles connectés à un pays. Il faudrait ensuite comparer les performances des câbles.

D’abord, en termes de nombre, on va avoir de grandes diversités. Le Sénégal, par exemple, est assez bien connecté et a maintenant une connexion supplémentaire de 2Africa. Mais, très vite, on tombe sur des pays qui sont peu connectés et qui subissent d’ailleurs régulièrement, lorsqu’un câble est coupé, de vrais problèmes pour leur connexion Internet.

La République du Congo en a deux depuis l’arrivée de 2Africa ; la Namibie qui en avait un, en a maintenant un autre avec Equiano ; le Mozambique se retrouve avec trois câbles.

Et puis il y a tout un tas de pays africains qui n’ont qu’un seul câble, ce qui les rend, du coup, extrêmement vulnérables : la Mauritanie, la Guinée, la Guinée-Bissau, le Togo, le Liberia, et la Sierra Leone ; pour l’instant pas de connexion sur les gros câbles, sur les nouveaux câbles.

Ensuite, il y a les pays enclavés, comme le Botswana, le Tchad, la Zambie, le Niger. Comme on l’a vu tout à l’heure pour la Suisse, ils se retrouvent, pour accéder à Internet, dépendants des réseaux terrestres, des réseaux des pays frontaliers, ce qui fait que ces pays pourront être intéressés par des offres satellitaires dans l’avenir, puisqu’ils n’auront plus à dépendre des pays frontaliers, par contre ils devront dépendre d’une technologie et donc d’un acteur privé.

On a passé pas mal de temps sur la première partie, c’est la plus longue, je vous rassure, mais ça permet quand même de savoir pourquoi, après, on peut parler de risques géopolitiques et environnementaux.

Risques géopolitiques et environnementaux

Comme nous l’avons vu, il y a quand même une multitude d’acteurs techniques et encore, comme vous le voyez, je me concentre vraiment sur les gros acteurs alors qu’en réalité l’écosystème numérique est extrêmement large, il y a énormément de technologies différentes. Il y a une multitude d’acteurs numériques mais, simplement, il y a une concentration des pouvoirs sur les socles critiques et au bénéfice, aujourd’hui, des multinationales.

Cette gouvernance d’Internet est largement transatlantiste pour des questions historiques, pour des questions aussi d’organisation politique puisqu’on sait très bien que la plupart des organisations de gouvernance d’Internet sont très majoritairement atlantistes. Á côté de ça, de notre côté, on a un droit du numérique que je qualifie de « passif » et de « défensif », c’est-à-dire que notre droit du numérique c’est le doit du numérique vu de la place du client et non pas du producteur de technologie, et il est extrêmement sensible à la puissance des lobbies puisque, aujourd’hui, les lobbies du numérique sont bien plus puissants que les lobbies du pétrole.

Là-dedans, on pourrait définir le modèle de la Big Tech en quatre points assez rapidement :

- impérialiste dans le sens où on a bien vu qu’il y a une forme de néocolonialisme, une recherche d’expansion territoriale et de mise en dépendance, donc un rapport de domination ;

- productiviste dans le sens où il encourage un consumérisme passif, faire du citoyen un consommateur passif, et également une forme d’avidité avec une absorption quasi systématique d’un secteur attenant, c’est le fameux extinguish de la société Microsoft dans les années 2000 ;

- totalitaire dans le sens où c’est leur gouvernement interne qui décide de leurs propres règles, comment concevoir leurs produits, comment vont circuler les données et ce qu’ils vont faire en R&D ;

- individualiste, car ils promeuvent, au final, une individualisation du droit, laissant le consommateur seul face à ses responsabilités, face à son contrat vis-à-vis de l’entreprise, et aussi parce qu’ils fonctionnent sur les zones de confort qui l’emportent sur l’intérêt collectif. Je pourrais passer beaucoup de temps sur ce point uniquement mais je n’ai pas énormément de temps donc je vais faire l’impasse ce coup-ci.

Sur les risques géopolitiques de la mise en dépendance, je vais en voir trois principaux qu’on a pu voir récemment.

Là c’est une photo de Russie quand Apple Pay et Google Pay ont coupé leurs services. En fait, les Russes n’étaient pas complètement bloqués mais il fallait qu’ils s’adaptent à la machine, il fallait qu’ils utilisent un autre mode de paiement comme la carte bancaire, tout simplement, pour payer leur ticket de transport. On peut couper un service quand on est producteur de technologie.

On peut couper l’accès au réseau ; l’autre exemple est celui de Cogent Communications [22] qui a coupé son service en Russie, ce qui est énorme puisque ça représentait, si je me souviens bien, 30 ou 40% du réseau au niveau russe, donc il y a donc eu une très forte baisse du trafic en Russie à cause de la coupure de Cogent Communications qui, je le rappelle, est une entreprise américaine.

Et il peut y avoir aussi autre chose qu’on va retrouver dans les plateformes centralisées, donc dans le cloud, la possibilité de couper les mises à jour, voire de corrompre un logiciel centralisé à distance. Je vous montre une de mes notes sur les États-Unis [23] — sachant que les États-Unis sont extrêmement dépendants de leurs propres acteurs technologiques. C’est assez intéressant : même Azure Government, par exemple, qui n’existe que pour les États-Unis, n’est pas complètement régionalisé. Certaines briques sont régionalisées et d’autres sont centralisées.

Chez nous, c’est un classement extrêmement simple qui permet de voir les dépendances majeures aux services cloud, Amazon étant le plus fort globalement en Europe et dans tous les pays. Si vous connaissez Amazon Web Services, vous savez pourquoi.

Microsoft arrive en deuxième position un peu partout.

On a une petite variation pour le troisième acteur en France, où OVH est quand même assez présent. Comme ce sont des chiffres de 2020, il faudrait que je remette à jour sur l’année dernière pour voir comment ça se passe maintenant sur les acteurs locaux.

Grosso modo, on voit que les très grands acteurs, aux technologies propriétaires, c’est-à-dire globalement sur ce qu’on appelle IaaS [Infrastructure as a Service], PaaS [Platform as a service] et cloud privé vont être plutôt les Big Tech.

Quand on parle de dépendance, il est très intéressant de parler de quelle dépendance. S’il s’agit juste d’une dépendance où j’ai stocké mes données quelque part mais que je peux vite les récupérer, ça va à peu près, en tout cas je peux corriger, c’est réversible. Le problème c’est ce qu’ils ont appelé dans ce fameux rapport Eurostat la sophistication [24], je parlerais plutôt de la criticité, mais c’est un terme à trouver, à adapter, sur le fait que dans les services cloud il y a des services logiciels qui sont critiques, qui sont complexes, qui ne sont pas faciles à reproduire, et d’autres réversibles.

Dans le degré de sophistication, c’est-à-dire le traitement des données, ce qui est utilisé pour le traitement des données, ce qui est utilisé comme outil de développement, donc les machines virtuelles, par exemple, qui font qu’en fait une entreprise est particulièrement dépendante et ne va pas pouvoir sortir facilement d’une technologie cloud, on se rend compte que 73% des entreprises et des acteurs, selon les activités, - vous pouvez le voir ici au niveau des listes d’activités -, sont fortement dépendants du cloud. Les utilisateurs du cloud sont plutôt fortement dépendants du cloud, ils ne font pas que stocker leurs données, ils utilisent évidemment toute la plateforme et, généralement, ils l’utilisent aussi dans les outils de développement, de traitement, de gestion de leurs données, etc.

Le niveau intermédiaire va être plutôt les services d’usage d’outils bureautiques en quelque sorte, et les services cloud de base, il s’agit plutôt de l’e-mail et du stockage.

Voilà, 73%, 10%, 15%, c’est très intéressant de voir cette répartition sur l’ensemble de l’Europe.

Ensuite les risques environnementaux de la mise en dépendance. Pourquoi envisager le risque environnemental au même titre que le risque géopolitique ? Parce que, comme on a pu le voir, les problématiques de dépendance sont les mêmes avec des impacts directs sur le territoire, donc sur nous, sur les citoyens. La stratégie d’expansion territoriale, qu’on va retrouver dans les rapports de force géopolitiques, sont liés à la gestion des risques environnementaux puisque, contrairement à beaucoup d’États et beaucoup d’entreprises européennes, ces entreprises des Big Tech ont déjà prévu, en quelque sorte elles ont un coup d’avance, elles ont fait pas mal de prospective sur comment développer leur réseau dans une situation de crise climatique.

Sur les controverses, vous connaissez probablement le cas de Nestlé Waters, une multinationale qui va puiser dans les nappes phréatiques dans les Vosges, en Allemagne, etc. On a mis 30 ans pour reconnaître le problème et pour fermer une usine Nestlé Waters en Allemagne, pas encore dans les Vosges, alors qu’il s’agissait seulement d’un commerce de bouteilles d’eau, c’est-à-dire sans conséquences sur le tissu industriel local, le produit étant la bouteille d’eau.

Qu’en est-il lorsqu’on se retrouve avec une multinationale qui tape dans les nappes phréatiques mais qui, en plus de ça, met en dépendance un réseau industriel local ? Son pouvoir augmente encore ! Au lieu de 30 ans, combien de temps va-t-on mettre pour réussir à négocier avec ces puissances économiques ?

En plus de cela, le problème qu’on voit, c’est la soumission politique aux États-Unis, qu’on voit encore plus aujourd’hui avec la guerre en Ukraine. Le modèle délétère de la multinationale et de l’entreprise monopolistique est qu’elle cumule à la fois des pouvoirs de négociation mais aussi la capacité d’échapper aux droits nationaux, ce qui est quand même assez pratique !

Face à cela, on peut se dire comment fait-on pour réduire ces dépendances ? Comment fait-on pour retrouver un peu le contrôle sur tout ça ? À mon sens, il y a plusieurs choses à définir, mais, ce qui est évident, c’est que définir une stratégie industrielle au long cours est aujourd’hui nécessaire. On pourrait se dire qu’on va contrôler la chaîne de dépendances, ce serait la souveraineté numérique maximale. Quelque part, c’est ce qu’essaient de faire les entreprises du numérique : les géants du numérique se développent horizontalement et verticalement pour contrôler l’ensemble de leur chaîne de production et mettre les autres en dépendance.

C’est ce qu’essaie aussi de faire la Chine dans sa stratégie nationale lorsqu’elle travaille sur les technologies critiques, ce qu’elle appelle les Qiā bó zi jishū — 掐脖子 技术 — c’est-à-dire les technologies du cou coincé. Le problème c’est que ça s’accompagne d’un excès de totalitarisme, puisque la décision reste au niveau national et que le niveau national s’impose aux entreprises et aux citoyens, avec toutes les dérives que cela comporte.

Quels communs ?

Comment fait-on, dans une société où l’on veut pouvoir conserver son autodétermination, pour se protéger et garantir une capacité d’autodétermination à tous les niveaux de la société, à la fois au niveau de l’État mais aussi au niveau de l’entreprise, du citoyen ?

Les communs sont évidemment une piste intéressante, Stallman [25] parlait du fait d’avoir des communs, de rendre libre les logiciels, les médicaments, les semences. Restent quand même, maintenant, des questions intéressantes pour les logiciels ouverts : est-ce qu’on peut tous devenir des citoyens éclairés des communs, donc capables de coder et de transformer le code ?

Et ensuite la question des socles collectifs, c’est-à-dire les infrastructures là-dedans : si le logiciel libre est un bon exemple de gestion du commun, comment fait-on pour gérer en commun une infrastructure et un socle technique critique matériel ? On voit qu’on a encore des modèles à construire pour nous réapproprier le commun.

Ensuite, les communs et le territoire.

À mon sens, on ne peut pas, aujourd’hui, opposer la gestion des communs et la valorisation d’un tissu industriel territorial. C’est peut-être quelque chose qu’on pourra faire plus tard, mais aujourd’hui on n’est pas encore assez mature pour le faire. Il faut donc jouer sur les deux plans : à la fois développer la gestion des communs comme on le fait aujourd’hui, comme on essaie de le faire, mais aussi valoriser un tissu industriel territorial, pour la simple et bonne raison que le maillage territorial a un sens stratégique très fort aujourd’hui ; l’adaptation au terrain environnemental et social nécessite d’être proche du territoire et de ses problématiques économiques, climatiques, etc.

Privilégier un maillage d’acteurs nombreux sur le territoire, ce fameux tissu industriel local qui permet, finalement, une meilleure adaptabilité et résilience comme c’est le cas sur un réseau. Si un acteur local ne fonctionne pas, on peut passer chez l’autre.

Contrôler les acteurs privés, en évitant les phénomènes de concentration et des monopoles économiques. Là on voit là l’intérêt politique de la chose, c’est-à-dire de ne jamais, en tant qu’État ou en tant que citoyen, être dépendant d’une force trop grande, pouvoir négocier avec un acteur plus petit, qu’il soit soumis à notre réglementation ; en fait c’est un rapport de force.

Évidemment le fait d’avoir un maillage territorial favorise également l’interopérabilité puisque celle-ci devient obligatoire pour passer de l’un à l’autre.

Enfin, le maillage territorial est particulièrement intéressant parce qu’il permet de prévenir les phénomènes de dépendance liés à l’adoption qu’il y a et qu’il va y avoir probablement de plus en plus des technologies satellitaires à orbite basse qui nécessitent un maillage territorial au sol des datacenters, d’où leur développement.

Chantier juridique

Au niveau des chantiers juridiques, je passe quand même un petit peu de temps là-dessus, mais très rapidement. Si vous êtes au courant du Digital Services Act [26], il y a deux articles extrêmement importants qui sont un peu cachés dans la masse, le 54 et le 57. Ils tentent de permettre au régulateur européen d’effectuer des contrôles sur le code sur place, sur les infrastructures, donc sur l’ensemble des éléments techniques, ce qui est quand même assez énorme comme demande, en tout cas une très bonne nouvelle, on peut le voir comme ça. Néanmoins, il y a énormément de freins. Par exemple, avant de pouvoir appliquer les articles 54 et 57, on propose aux entreprises de financer elles-mêmes des audits indépendants sur leur code et leurs infrastructures, donc autant dire qu’on peut se retrouver avec le même phénomène que les Big Pharma ou les entreprises énergétiques, où les audits sont faits mais favorablement à l’entreprise.

Il faut quand même continuer à faire évoluer le droit du numérique dans ce sens, mais éviter évidemment le phénomène de capture du régulateur qui est principalement dû à la force des lobbies.

Continuer à lutter pour l’ouverture du code parce que, en réalité, c’est la vraie solution, la meilleure solution. Elle pose le problème éventuel de la propriété intellectuelle quand on est dans une vision marchande mais, en revanche, c’est une réponse idéale pour le citoyen et le régulateur, même s’il reste la question de savoir si nous serons tous des développeurs ; je ne pense pas.

Répondre également à la logique d’individualisation du droit, donc le fait de rester seul devant son interface à accepter un contrat avec une entreprise privée, sans avoir la possibilité de voir ce qu’il y a derrière.

Également très important dans le chantier juridique c’est d’arrêter de se borner à la notion de données personnelles qui sont aujourd’hui trop limitées aux données nominatives, alors que certaines données personnelles ne sont aujourd’hui pas prises en compte dans le RGPD [27], comme la possibilité de tracer le parcours d’un utilisateur, par certaines applications utilisées dans l’UX Design [User eXperience Design]. Également la notion de données stratégiques, qui sont complètement absentes aujourd’hui du droit européen.

Inclure comme obligation légale le diagnostic de dépendance numérique des États membres de l’UE. Je vous ai montré tout à l’heure quelques screens du rapport Eurostat sur les dépendances au cloud. C’est un bon début et il serait très intéressant de voir cette démarche systématisée afin de mieux gérer les dépendances à l’avenir.

L’élargissement du plan de vigilance au niveau des entreprises. Quelque chose de très intéressant, qui existe déjà : il suffirait d’enrichir l’obligation du plan de vigilance qui aujourd’hui concerne des règles de sécurité globales, standards, un petit peu les dépendances au niveau informatique et qui, en fait, pourrait être beaucoup plus enrichi sur cette question des dépendances technologiques. Il pourrait y avoir toute une partie de plan de vigilance là-dessus qui permettrait aussi à l’État d’avoir une vision plus globale des dépendances sur son territoire.

Une réglementation anti-monopolistique supposant, dans le cas présent de déséquilibre — puisqu’on est vraiment dans un déséquilibre de forces en notre défaveur — d’assumer un protectionnisme ciblé qui, lui, est très utilisé par les pays dominants.

Chantier politique

Dans le chantier politique, évidemment, le développement de politiques de contribution aux logiciels ouverts. Il y a des efforts qui ont été faits, notamment à la Direction interministérielle du numérique, mais ça ne suffit pas. Aujourd’hui on est plus dans une idéologie du Libre, même à la Dinum, que dans une politique de contribution. La contribution se fait beaucoup, aujourd’hui, dans le volontariat au niveau du secteur public ; il n’y a pas de financement dédié à la contribution ou très peu, à la marge.

La lutte anti-monopoles qui pourrait être encouragée par la commande publique évidemment. Cette commande publique, plutôt qu’être simplement un don d’argent — donner de l’argent public à un acteur privé — devrait être une possibilité d’améliorer les logiciels, c’est-à-dire un levier d’amélioration mais également de diffusion des produits numériques. Au lieu d’acheter un produit sur étagère, en gros, on participerait en tant qu’État à améliorer le logiciel par la commande publique.

Sortir de la logique de transformation numérique à tout prix, tout simplement parce qu’on voit bien où elle nous mène : elle nous mène à devenir des consommateurs, à choisir des produits sur étagère pour aller plus vite.

Chantier technologique

Sur le chantier technologique, je mets quelques priorités : reprendre le contrôle sur les logiciels et les OS de la vie de tous les jours et pas forcément investir sur l’intelligence artificielle. Évidemment que c’est intéressant, mais si vous n’avez pas la propriété des socles critiques, comment parler d’indépendance, de souveraineté numérique ? Donc revenir sur les logiciels basiques, la bureautique, le mail, les OS.

Les centres de données dans leur adaptation au territoire, donc une réflexion possible au niveau européen mais également au niveau national. Au niveau européen, parce que si les pays d’Europe du Nord ont des conditions climatiques intéressantes, il y aurait peut-être des partenariats à faire sur ces sujets-là au niveau européen.

Remplacer progressivement les couches logicielles des plateformes cloud par des technologies locales et du logiciel ouvert, ça existe déjà.

Dépendance inter-industrielle de l’industrie des semi-conducteurs : pour construire des semi-conducteurs, il faut aussi avoir la technologie de pointe qui permet de le faire et d’avoir une avance technologique sur les autres. C’est ce qui nous a souvent désavantagés dans ces secteurs-là innovants : les machines étant produites par les Américains et aujourd’hui de plus en plus par les Chinois, on est toujours dépendant, quelque part, du degré de sophistication de l’outil. Là aussi, on a des acteurs.

Ingénierie marine et spatiale, parce qu’évidemment, dans le cas des infrastructures, garder notre ingénierie marine, nos armateurs, c’est un pouvoir technologique, c’est un pouvoir géopolitique. Et spatial parce que, même si je n’en ai pas beaucoup parlé, je pense que vous avez compris que je fais quand même le lien entre ce qui se passe aujourd’hui au niveau des technologies satellitaires et ce qu’on a sur le territoire.

La bonne nouvelle, c’est que tout existe déjà.

La formation

Je dois finir, je suis vraiment désolée, j’ai juste un dernier point parce que c’est quand même très important et je n’en ai pas du tout parlé : aujourd’hui il y a aussi une autre stratégie de mise en dépendance au-delà de ce dont on a déjà parlé, c’est celle de la formation. Ce n’est pas seulement aujourd’hui, c’est évidemment depuis un certain temps.

L’ANPE avait déjà, en 2006, des contrats avec des formateurs Microsoft pour la bureautique, etc. Aujourd’hui, on a les Google Ateliers Numériques dans les universités et à destination des familles, et quand je parle des universités c’est à la fois les petites comme les très grandes et très connues comme la Sorbonne.

Microsoft Simplon forme des techniciens de plateforme, c’est-à-dire favorise, en fait, l’enfermement, dès l’entrée dans le métier, à une plateforme ;

le CyberTour de Google des Chambres de commerce et d’industrie,

les centres de formations professionnelle d’Amazon Web Services.de Google

Désormais ces entreprises font notre éducation au numérique. Quand je vous parle des Google Ateliers Numériques pour les familles, il y a vraiment des Google Ateliers locaux pour les familles, il y en a à Saint-Étienne, à Lyon, à Marseille, qui vont aussi permettre aux parents de montrer à leurs enfants quels services ils vont pouvoir utiliser pour faire leurs recherches, pour jouer, etc.

Quelle est la solution ? Peut-être revenir à des choses qu’on avait un peu testées à l’époque, dans les années 70 : ouvrir la boîte noire dès l’école en privilégiant l’interdisciplinarité dans l’appréhension des savoirs techniques essentiels. On a eu des expérimentations de 1970 à 1976 ; c’était l’expérimentation « 58 lycées » [28], sous Georges Pompidou, qui a été arrêtée avec Giscard d’Estaing. On pouvait former des profs dans 58 lycées. On les emmenait dans des usines, sur le terrain, voir comment on construisait des ordinateurs et on leur apprenait également ce qu’on appelle le Langage Symbolique d’Enseignement, LSE [Langage Symbolique d’Enseignement], qui est un langage informatique simplifié et qui leur a permis de fabriquer, en six ans, 400 logiciels. Ces 400 logiciels et ce temps de formation étaient rémunérés par l’État, ce n’était pas volontaire, ce n’était pas sur le temps libre ; les profs étaient payés par l’État pour faire cela.

L’interdisciplinarité c’est aussi pouvoir parler aux enfants des réseaux, des câbles, de toute la matérialité du numérique, pas pour en faire des professionnels de réseaux mais en les intégrant, tout simplement, aux cours qu’ils ont déjà, la géographie, l’histoire. C’est déjà le cas dans certaines filières techniques. Pourquoi ne pas le faire chez tous puisque le programme d’histoire est pratiquement identique sauf que, dans certains cas, on peut ajouter une information supplémentaire, montrer une carte des câbles, tout simplement. On peut également parler, lors des cours d’éducation civique, des réseaux sociaux mais pas seulement : expliquer comment ça fonctionne, désolée pour ceux qui se disent que c’est pas possible, mais montrer une ligne de code, voir comment ça fonctionne. Ils ne sont pas bêtes, je l’ai testé avec des étudiants en art. Je passais 30% de l’ensemble du cours à leur fournir des connaissances techniques qui leur permettait de lire des lignes de code très simples ; ça marche très bien et ça leur permet de mieux comprendre les choses ensuite.

Et ensuite, former des citoyens, des professionnels et des décideurs aux risques et aux externalités négatives du numérique de leur choix : quelle est la conséquence de leurs choix technologiques ? Ça pourrait par exemple être inclus dans les formations de sécurité obligatoires qui existent déjà. J’ai terminé.

[Applaudissements]